2025-3-21版本,现在迭代很快的,大家及时跟新最新版

一、项目核心特点

OpenManus 是由 MetaGPT 团队开发的智能体开发框架,具备以下特性:

- 快速原型搭建:3 小时完成智能体基础开发

- 工具调用支持:必须选择支持 Function Calling 的模型

- 持续迭代升级:即将推出基于强化学习的优化版本(OpenManus-RL)

二、环境搭建全流程

- 必备工具安装

- 代码编辑器:下载 VSCode(官网:https://code.visualstudio.com/)

- 环境管理工具:安装 Miniconda(Windows 用户直接运行:https://repo.anaconda.com/miniconda/Miniconda3-latest-Windows-x86_64.exe)

- 获取项目代码(三选一)

方案一:终端执行加速克隆命令

git clone https://gh.llkk.cc/https://github.com/mannaandpoem/OpenManus

方案二:下载国内镜像压缩包

访问 https://gh.llkk.cc/https://github.com/mannaandpoem/OpenManus/archive/refs/heads/main.zip

方案三:官方仓库直接下载 ZIP - 配置 Python 环境

打开 Miniconda Prompt 执行:

conda create -n open-manus python=3.12 # 创建专用环境

conda activate open-manus # 激活环境

cd OpenManus # 进入项目目录 - 依赖安装步骤

设置清华镜像加速:

pip config set global.index-url https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

安装核心依赖(如失败切换腾讯源):

pip install -r requirements.txt

可选浏览器组件:

playwright install

三、模型配置关键说明

配置文件路径:项目目录/config/config.toml

Ollama 配置示例(注意127.0.0.1不要换成localhost):

[llm] #OLLAMA:

api_type = ‘ollama’

model = “qwen2.5-coder:7b”

base_url = “http://127.0.0.1:11434/v1”

api_key = “ollama”

max_tokens = 4096

temperature = 0.0

[llm.vision] #OLLAMA VISION:

api_type = ‘ollama’

model = “qwen2.5-coder:7b”

base_url = “http://127.0.0.1:11434/v1”

api_key = “ollama”

max_tokens = 4096

temperature = 0.0

重点注意:

- API 密钥获取后需完整替换(保留引号)

- 模型必须支持 tools 调用功能

- 不同平台的同名模型可能存在功能差异

四、启动与使用

基础启动命令:

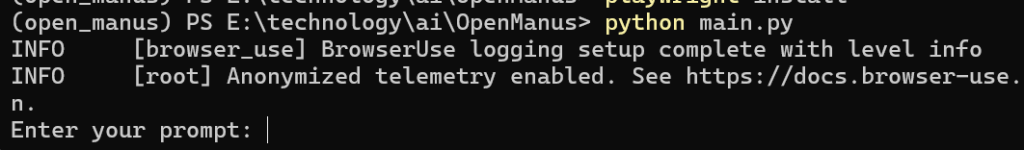

python main.py

成功运行后会显示交互提示:

进阶功能启动:

- 工具演示版:python run_mcp.py

- 多智能体测试版:python run_flow.py(需多模型配置)

大家有条件就直接用Key,当然本地部署比如Ollama也行,但是如果本地显卡不好的话,这个就容易出很多问题。

可以使用GPT要魔法。

DeepSeek目前只支持 deepseek-chat 模型

硅基流动

官方网站:https://cloud.siliconflow.cn,

可以通过下面我的邀请码获取2000万token,免费使用,一起白嫖

https://cloud.siliconflow.com/i/OEjSMlfq

配置如下:

# Global LLM configuration

[llm]

model = "Qwen/QwQ-32B"

base_url = "https://api.siliconflow.cn/v1"

api_key = "sk-..."

max_tokens = 8192

temperature = 0.0

# Optional configuration for specific LLM models

[llm.vision]

model = "claude-3-5-sonnet"

base_url = "https://api.openai.com/v1"

api_key = "sk-..."别的也都差不多,都是换个model和url以及api_key就行。

发表回复